Eine ganz kurze Geschichte der Technik

Leitartikel von Ernst Peter Fischer

Menschen haben sich von Anfang an als technisch erfindungsreich erwiesen – Technik leitet sich von Kunstfertigkeit ab – und in ihrer Geschichte früh angefangen, Metall zu bearbeiten, Glas herzustellen, Hebel zu konstruieren und Schrauben anzufertigen, die von Aristoteles als Maschinen bezeichnet worden sind. Mit ihrer Hilfe haben sich Menschen von der Natur entfernt, und „der Abstand zur Natur ist das Wesen des Menschen selbst“, wie es Karl H. Metz in seiner „Geschichte der Technik in der westlichen Zivilisation“ mit dem Titel „Ursprünge der Zukunft“ formuliert hat.

Das Buch stellt „Das Prinzip Werkzeug“ bis zum Beginn der Moderne vor, lässt diesem Kapitel „Das System Industrie“ in den Jahren von 1770-1970 folgen, vergisst auch das „Kriegszeug“ als „Negation des Werkzeugs“ nicht und schließt mit dem „technologischen Zeitalter“ ab, in dessen Verlauf der Autor einen „Übergang in die posthumane Gesellschaft“ erwartet. Hier soll nicht versucht werden, aus den vielen hundert Seiten der „Ursprünge“ die wenigen Worte herauszufiltern, die eine ganz kurze Geschichte der Technik ergeben. Was müsste nicht alles über Erfindung von Maschinen, die Entstehung der Arbeitsgesellschaft, die Stufen des Industriesystems mit seinen neuen Energien, seiner wachsenden Mobilität, seiner vielfältigen Medienlandschaft und manchem mehr geschrieben werden. Hier soll versucht werden, im Überblick von dem Verhältnis zu erzählen, das Menschen und Maschinen im Laufe ihrer gemeinsamen Geschichte entwickelt haben – wobei die erste Begegnung des Autors mit so einer Apparatur im Theater stattfand, als ein „deus ex machina“ aus den Kulissen kam und die Gemüter beruhigte.

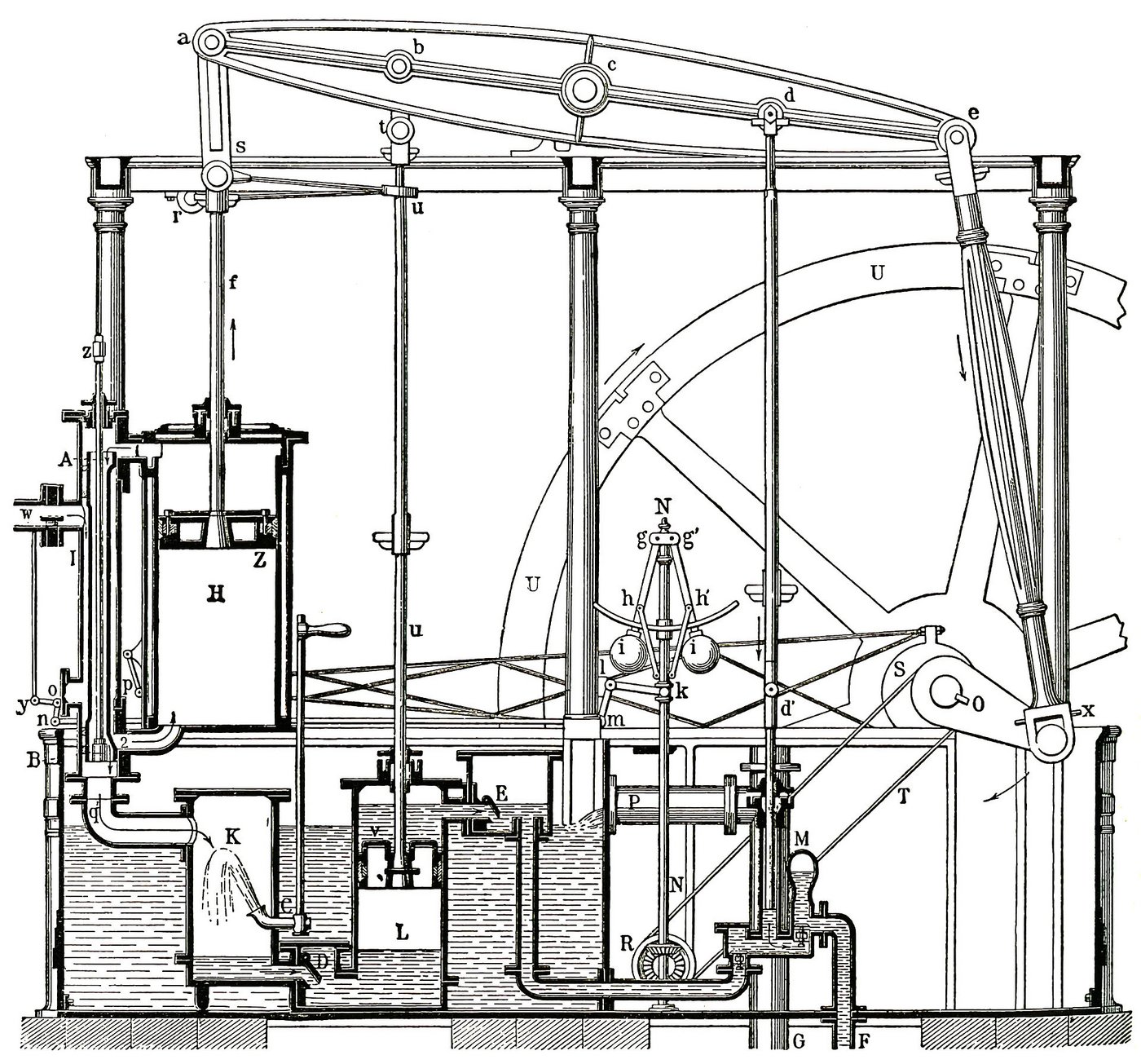

Die sich in der Konstruktion von Maschinen ausdrückende Geisteshaltung brachte im Laufe der Zeit den Flaschenzug, eine frühe Form von Hochöfen, das Wasserrad, eine erste Lochkamera und um 1450 den Buchdruck hervor. So großartig diese Techniken sind, die eigentliche Geschichte der Verbindung von Mensch und Maschine setzte mit der industriellen Revolution am Ende des 18. Jahrhunderts ein, zu der vor allem die Kohleenergie und die Dampfmaschine beigetragen haben. Historiker haben nach der ersten längst eine zweite, dritte und vierte industrielle Revolution ausgemacht, bei denen die Maschinen intelligenter und vernetzter agieren und Menschen ihren Abstand zur Natur vergrößern.

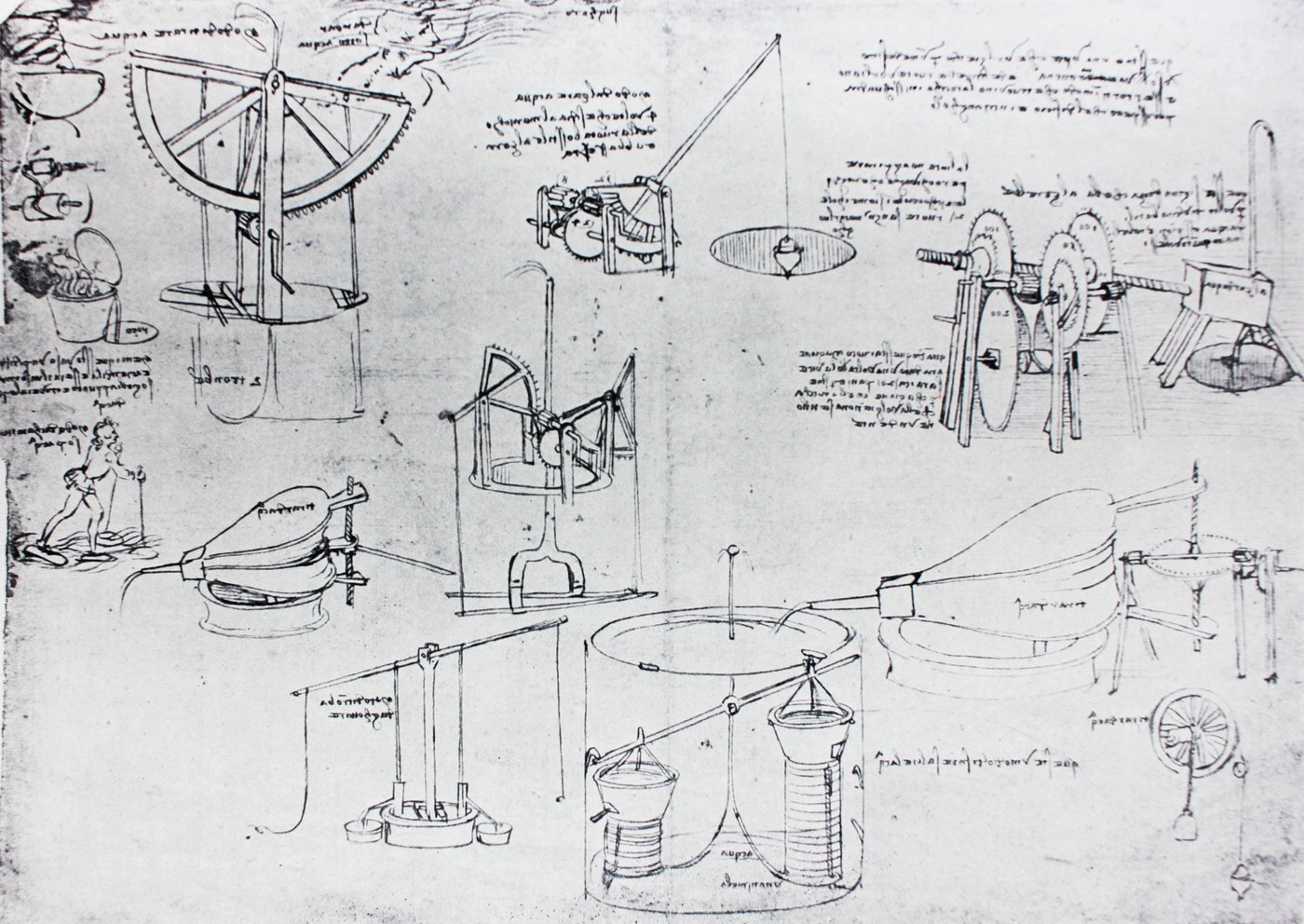

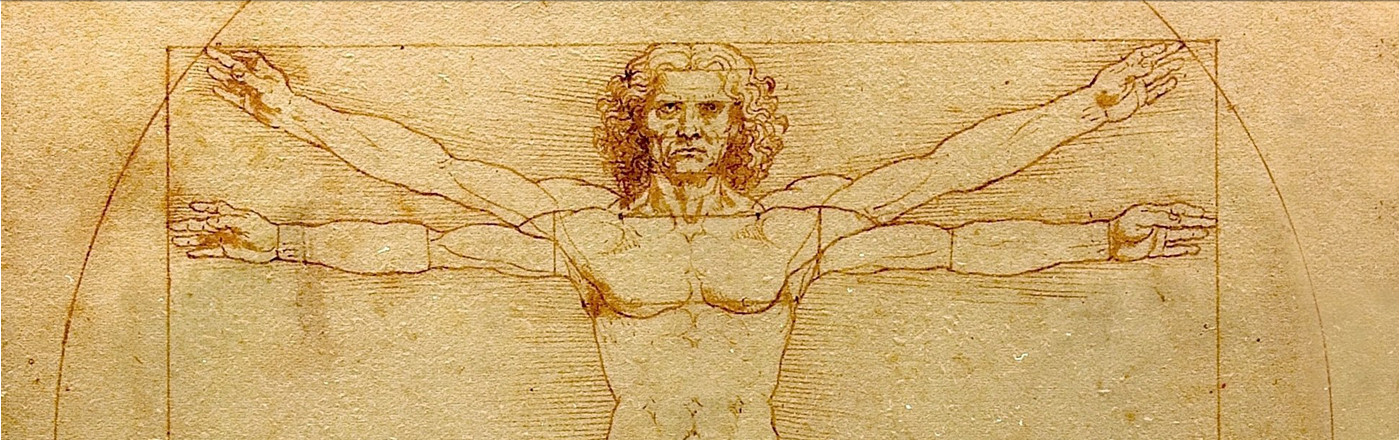

Da jede Geschichte die Aufgabe hat, die Gegenwart zu erklären, kommt keine Version um einen Hinweis auf Leonardo da Vinci herum. Schließlich leben Menschen heute in einer „Leonardo-Welt“, womit „eine wissenschaftsgestützte technische Welt“ gemeint ist, die sich Menschen selbst gemacht haben, wie es Jürgen Mittelstrass ausgedrückt hat, und zwar mit Maschinen, die erst von seinem Wissen abhängen und seit 1950 die Frage aufwerfen, „Können Maschinen denken?“.

Als Leonardo über den Einsatz von Maschinen nachdachte, meinte er, „eine unsichtbare Macht [spirituale potenza], unkörperlich und ungreifbar“, ausfindig machen zu können, welche sie antreibt und Arbeit verrichten lässt. Dieser Gedanke klingt sehr nach der Energie, aus der die aktuelle Leonardo-Welt ihren Schwung bezieht und die in der Wissenschaft erst auftauchte, als Physiker im frühen 19. Jahrhundert zu verstehen versuchten, was Maschinen für ihre Leistung brauchen. Man musste sie auch steuern, und so ersann man das Konzept der Rückkopplung durch einen Fliehkraftregler, für das man bald das englische Wort „governor“ – Steuerelement – einsetzte. Es wurde in den 1940er Jahren von den Ingenieuren, die sich für die „Regelung und Nachrichtenübertragung im Lebewesen und in der Maschine“ interessierten, als „Steuermann“ gelesen, was auf Griechisch „kybernos“ heißt und der Kybernetik ihren Namen gab. Deren Vertreter meinten, eine Gesellschaft durch das Studium der Kommunikationsmöglichkeiten mit technischem Gerät verstehen zu können. Die ersten beiden Silben der Kybernetik tauchen heute im „Cyberspace“ auf, mit dem eine virtuelle Welt gemeint ist, die von Computern geliefert und ausgestattet wird.

Die Elektrifizierung der Welt

Wenn man einen einzelnen Begriff für die Entwicklungen nach der ersten industriellen Revolution sucht, kann man von der Elektrifizierung der Welt sprechen, die weltweit soziale Utopien heraufbeschwor und etwa Lenin die Formulierung eingab, dass „Kommunismus gleich Sowjetmacht plus Elektrifizierung“ sei. Während Lenin von Massenproduktionen dank elektrischer Energie mit ungeheuren Folgen für das Leben der Gesellschaft träumte, setzten kapitalistische Systeme diesen Gedanken mit Fließbändern praktisch um. Westlichen Wissenschaftlern gelang daneben – ohne politischen Auftrag – die Erfindung der Elektronenröhre, die zur Verstärkung kleiner Energiebeträge diente, was in der Nachrichtenvermittlung eingesetzt werden konnte und vor allem den frühen Telefonapparaten half, die Signale der Stimme so zu verstärken, dass sie weite Entfernungen überwinden konnten. Übrigens – das Wegfallen der visuellen Kommunikation beim Telefonieren wirkte merkwürdig verstörend. „Die Körperlosigkeit des Redens bei gleichzeitigem Schwinden des Raumes, auch die im Prinzip universelle Verfügbarkeit des anderen auf einen maschinellen Vorgang hin, beunruhigte und faszinierte die Zeitgenossen gleichermaßen“, wie bei Karl H. Metz zu lesen ist. Er meinte zum Beispiel „Marcel Proust, den die Telefonstimmen an Worte aus der Unterwelt erinnerten“, „Sigmund Freud, der die psychoanalytische Situation mit der des Telefonierens verglich“, und „die Nutzer sexueller Telefonkontakte in ihrer Dualität von Körperlosigkeit und Körperbegehren, die in den USA lange Zeit am häufigsten das Telefon nutzten.“ Wenn aus einem Apparat eine Stimme kam, meinte man, in ihm stecke eine Seele, was erklärt, warum Menschen sie heute in den iPhones vermuten, an denen sie sich festhalten.

Als die Elektronenröhre entwickelt wurde, konnte Heinrich Hertz zeigen, dass durch die Bewegung elektrischer Ladungen ein Feld entsteht, das sich in Form elektromagnetischer Wellen durch den Raum ausbreitet. Als ein Funke, der zwischen zwei an einer stromdurchflossenen Spule anbrachten Metallkugeln übersprang, gleichfalls auch bei einem davon entfernten Paar auftrat, hatte der Physiker Hertz den ersten Schritt hin zu dem Medium namens Rundfunk getan. Die anschließende Entfaltung der Informationstechnologie wäre ohne die von Hertz beobachteten Wellen und die Elektronenröhre nicht möglich geworden, wobei der Verstärker seine Qualitäten und Anwendungsmöglichkeiten erst voll und ganz erkennen lässt, nachdem aus den Röhren erst Transistoren und dann integrierte Schaltkreise aus Festkörperelementen geworden waren.

Maschinen und Computer

Bevor darauf eingegangen wird, muss die Maschine erwähnt werden, die den Menschen die Beweglichkeit (Mobilität) gibt, die in der Renaissance als Prinzip des Lebens angesehen wurde. Gemeint ist das Automobil, das Verbrennungsmotoren nutzte, deren Entwicklung sich bis auf die Dampfmaschine zurückverfolgen lässt, auch wenn die zuerst als Pumpe diente. Bald ersann man Geräte, um ihre Arbeitsleistung umzulenken und Fahrzeuge wie Automobile zu schaffen. Anzumerken ist, dass die Mühelosigkeit von Bewegung in der Kulturgeschichte als Attribut von Göttern betrachtet wurde und Menschen in allen Epochen und Kulturen dazu neigen, die Schöpfung zu vollenden und selbst Götter zu werden.

Zum „Gesamtproblem der Motorwagenerfindung“ für die Allgemeinheit gehörte es, eine für Kraftfahrzeuge und ihren Treibstoff nötige Infrastruktur mit Tankstellen aufzubauen, was bis zum Beginn des Zweiten Weltkriegs gelungen ist, der einen Wechsel der Blickrichtung nahelegt. In dessen Verlauf entwarf der aus Ungarn stammende Mathematiker John von Neumann nämlich eine Rechenmaschine, deren Architektur die Elemente enthält, die einen modernen Computer ausmachen: Da gibt es ein Rechenwerk, ein Steuerwerk, einen Speicher und Vorrichtungen für die Ein- und Ausgabe von Daten oder Informationen. Die dazugehörigen Überlegungen konnten von der Konzeption einer Maschine profitieren, die dem Engländer Alan Turing zu verdanken ist und seinen Namen trägt. Mit der bereits 1936 entworfenen Turingmaschine wollte sein Erfinder die Grenzen der Beweisbarkeit und Berechenbarkeit in der Mathematik erkunden, und er betrachtete dazu Informationen in diskreter Form, was in Zukunft alle Computer übernehmen sollten.

Seit 1943 die Arbeit am Manhattan-Projekt begonnen hatte, das dem Bau von Atombomben diente, stieg der Bedarf an Berechnungen („Computations“) in einem zuvor unbekannten Ausmaß an. 1945 kam eine (analoge) elektronische Rechenanlage zum Einsatz, die ENIAC (Electronic Numerical Integrator and Calculator) hieß, mit 18.000 Elektronenröhren ausgestattet war, rund 30 Tonnen wog und eine Standfläche von 140 m2 einnahm. ENIAC war 1000mal schneller als alle anderen Rechenmaschinen ihrer Zeit – schneller auch als der berühmte Prototyp Z3 des in Deutschland tätigen und von seinen Landsleuten lange Zeit ignorierten Ingenieurs Konrad Zuse. Er stellte ab 1938 programmgesteuerte mechanische Rechner her, die bis zu einem Z4 führten, den Zuse 1949 an die ETH in der Schweiz verkaufen konnte. Die Vorstellung, dass man Computer programmieren müsse, kann zwar auf das ENIAC-Team zurückverfolgt werden, aber erst 1957 hat das Unternehmen IBM eine Programmiersprache für all seine Maschinen eingeführt, die FORTRAN hieß, was „Formal Translation“ abkürzte.

Moderne Computer brauchen für komplizierteste Berechnungen nur noch Bruchteile von Sekunden, was die Frage aufwirft, was diese Entwicklung bei gleichzeitiger Miniaturisierung ermöglicht hat. Die Antwort liegt in den Transistoren, deren Bauprinzip im Dezember 1947 gefunden werden konnte, als Physiker systematisch zu erforschen versuchten, was zuvor nebenbei erkundet worden war, nämlich die Eigenschaften von Kristallen oder Festkörpern, die man Halbleiter nannte. Nach 1945 nahm man deren Entwicklung umfassend in Angriff, und 1947 gab es den ersten Transistor. Die Bezeichnung ist ein Kunstwort, das sich aus Transfer (Übertragung) und Resistance (Widerstand) zusammensetzt. So ein „Übertragungswiderstand“ konnte Strom abblocken oder verstärken. Er lieferte nicht nur das, was die alte Elektronenröhre konnte – er tat dies besser und zuverlässiger, und er war darüber hinaus sehr viel kleiner und billiger herzustellen.

Der Halbleiter, der anfangs das größte Interesse fand, ist als Silizium bekannt. Er findet sich zum Beispiel im Sand, der vorwiegend aus Siliziumdioxid besteht, das in reiner Form auch als Quarz bekannt ist. Das chemische Element heißt auf Englisch „silicon“, und das berühmte Silicon Valley, das in den 1970er Jahren die Wiege der amerikanischen Computerindustrie wurde, trägt seinen Namen.

Transistoren und Chips

Was wichtig zu wissen ist: Der Transistor hätte ohne Kenntnis der Quantenmechanik nicht erfunden werden können. Im 18. Jahrhundert hat noch jemand eine Dampfmaschine konstruieren, ohne die Gesetze der Thermodynamik zu kennen. In der zweiten Hälfte des 20. Jahrhunderts reichte es nicht mehr, etwas zu wollen, jetzt musste man etwas wissen, um grundlegend Neues zu schaffen, wie die Erfindung des Transistors zeigt. Hier vollzieht sich die Wandlung einer Industrie- in eine Informations- oder Wissensgesellschaft, der immer neue Techniken entspringen.

Zu ihnen gehört die Informationstechnologie, deren erste Theorie 1948 vorgelegt wurde, als Claude Shannon darüber nachdachte, wie sich die Übertragung von Nachrichten besser bewerkstelligen lässt. Um definieren zu können, was „besser“ heißt, schlug Shannon vor, alle Zeichen in binärer Form darzustellen – also als Folge von 0 und 1 – und die Information einer solchen Zahlengruppe durch die Menge der benötigten Stellen festzulegen. Er sprach von „binary digits“, was als Bit abgekürzt wurde und in dieser Form Einzug in den sprachlichen Alltag gehalten hat. Das Ziel von Shannon lag nicht nur darin, Möglichkeiten zu schaffen, mit denen Informationen gemessen werden konnten. Er wollte Informationen in elektronischen Schaltkreisen als Nachrichten übermitteln, und genau dafür waren die binären Einheiten gut zu gebrauchen: Da floss ein Strom – das zählte als 1 – oder da floss kein Strom – das zählte als 0. In seinen zwei Arbeiten mit dem Originaltitel A Mathematical Theory of Communication von 1948 schlägt Shannon vor, den Informationsgehalt einer Nachricht dadurch zu bestimmen, dass man sie erst binär ausdrückt und dann die Anzahl der Nullen und Einsen ermittelt. Man kann die Ziffern, mit denen wir gewöhnlich rechnen – also 0, 1, 2, 3, 4 und so weiter –, binär darstellen durch 0, 1, 10, 11 und 100. Man kann auch Buchstaben binär darstellen, und zwar durch einen Code, also durch eine Vorschrift, nach der ein Zeichen (ein Buchstabe) in ein anderes Zeichen (eine Zahl) verwandelt wird. Vielen fällt dabei der Morse-Code ein, bei dem aus Buchstaben eine Kombination aus langen und kurzen Impulsen wurde, mit denen telegrafiert werden konnte. In der modernen Computertechnologie wird häufig ein Code eingesetzt, der mit acht Bits operiert, weshalb man diese Einheit als Byte zusammenfasst. Wie sich herausstellte, reicht 1 Byte mit seinen 28 – also 256 – Möglichkeiten aus, um sämtliche Buchstaben und Zahlen nebst Sonderzeichen der Sprache (etwa Doppelpunkte) zu kodieren, und damit können alle Informationen einem Computer als elektrische Signale eingegeben werden.

World Wide Web und Handys

Sie lesen lieber aus einem Buch? Sie finden diesen Artikel auch in unserem dritten Buch zu dieser Webseite, "Gottes Schöpfung und menschliche Technik" (Darmstadt 2022). 17 namhafte Autoren führen den Dialog mit Wissenschaft und Technik angesichts der Gottesfrage weiter.

Bildnachweis

- The mechanisms. Atlantic code 7 verso a. By Leonardo Da Vinci in the vintage book Leonardo da Vinci by A.L. Volynskiy, St. Petersburg, 1899: Adobe Stock # 270261378 ©wowinside

- Presumed self-portrait of Leonardo (c. 1510) at the Royal Library of Turin, Italy. (Selbstportrait Leonardo da Vinci) © Wikimedia Commons

- Wattsche Niederdruckdampfmaschine aus der 4. Auflage des Werkes Meyers Konversations-Lexikon von 1885-1890 © Wikimedia Commons

- Silicon Valley; specifically, the North First Street area of San Jose, looking southbound down Interstate 880 towards downtown San Jose. Photographed by user Coolcaesar on 1 June 2014. © Wikimedia Commons

Diesen Beitrag fand ich...

Stationen der Technikgeschichte

Welche Bedeutung hat Technik für die menschliche Entwicklung?

In seiner ganz kurzen Geschichte der Technik skizziert Ernst Peter Fischer die Stationen der Technikgeschichte. Welche Bedeutung hat Technik aus ihrer Sicht für die menschliche Entwicklung? Überzeugt Sie die Darstellung?

Kommentare (0) Keine Kommentare gefunden!